零阶优化笔记

一、引言与背景

广义上的“零阶优化(Zeroth-Order Optimization, ZOO)”泛指所有仅能通过函数值进行优化的算法,亦称为无梯度(gradient-free)优化或 bandit 优化。传统方法可粗略分为以下两类:

基于直接搜索的方法 (Direct Search-Based Methods, DSM),例如 Nelder-Mead 单纯形法、坐标下降、模式搜索等;

基于模型的方法 (Model-Based Methods, MBM),例如置信域方法(Trust-region methods)等。

此外,还有两类典型的无梯度优化算法:

进化算法 (Evolutionary Algorithms, EA),即基于种群的通用元启发式无梯度算法,包括著名的粒子群优化(PSO)和遗传算法(GA);

贝叶斯优化 (Bayesian Optimization, BO),其核心思想是将目标函数建模为一个高斯过程(Gaussian Process, GP)。

然而,这些传统无梯度方法存在两个主要缺点:

这一局限性催生了狭义的 ZOO 算法 ——即作为一阶(First-Order, FO)优化方法的无梯度对应形式。这类算法通过函数值来估计梯度或随机梯度,从而复用一阶优化框架。其主要优势包括:

易于实现 :只需对常用梯度算法进行少量修改,将一阶梯度 Oracle 替换为基于函数值的零阶梯度估计 Oracle 即可;

适用性强 :在导数难以计算或不可用的场景下,仍可高效地进行近似优化;

理论性能优良 :其收敛速度(即分析复杂度)可与一阶梯度算法相媲美。

二、核心概念:什么是零阶优化?

零阶优化(Zeroth-Order Optimization, ZOO)是梯度无关优化 (Gradient-Free Optimization)的重要分支,旨在求解如下形式的优化问题:

min x ∈ X f ( x ) , \min_{\mathbf{x} \in \mathcal{X}} f(\mathbf{x}),

x ∈ X min f ( x ) ,

其中目标函数 f : R p → R f: \mathbb{R}^p \to \mathbb{R} f : R p → R 黑盒 (Black-Box)——我们无法获得其梯度 ∇ f ( x ) \nabla f(\mathbf{x}) ∇ f ( x ) 或 Hessian ∇ 2 f ( x ) \nabla^2 f(\mathbf{x}) ∇ 2 f ( x ) 唯一可执行的操作是向系统输入一个点 x \mathbf{x} x 并接收对应的函数值 f ( x ) f(\mathbf{x}) f ( x )

2.1 零阶 Oracle(Zeroth-Order Oracle)

在优化理论中,Oracle 是一个标准的抽象模型,用于刻画优化算法所能获取的关于目标函数的局部信息 。算法通过向 Oracle 提交查询,并接收其返回的信息,以此驱动迭代更新。

根据所返回信息的阶数,Oracle 可分为以下几类:

零阶 Oracle :对任意查询点 x ∈ R p \mathbf{x} \in \mathbb{R}^p x ∈ R p 函数值 f ( x ) f(\mathbf{x}) f ( x ) 一阶 Oracle :返回函数值 f ( x ) f(\mathbf{x}) f ( x ) 梯度 ∇ f ( x ) \nabla f(\mathbf{x}) ∇ f ( x ) 二阶 Oracle :返回函数值、梯度及Hessian 矩阵 ∇ 2 f ( x ) \nabla^2 f(\mathbf{x}) ∇ 2 f ( x )

零阶优化(Zeroth-Order Optimization, ZOO)问题的设定即为:优化算法仅能访问零阶 Oracle,且在有限次查询内完成优化任务 。这一设定精确刻画了大量现实场景,例如:

黑盒函数(如商用大模型 API)仅提供输入-输出接口;

物理仿真器(如流体动力学模拟)的内部梯度不可解析;

隐私保护场景下梯度信息被禁止访问。

在此框架下,查询复杂度 (Query Complexity)——即达到特定精度 ϵ \epsilon ϵ

局部黑箱假设 (Local Black-Box Assumption):Oracle 是“局部”的,即其在点 x \mathbf{x} x x \mathbf{x} x f f f

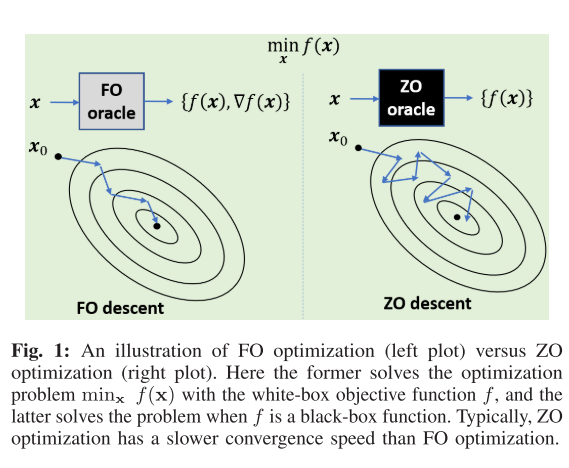

2.2 从黑盒到梯度:核心思想与图示

ZOO 的核心思想是:通过有限次函数值查询,构造一个对真实梯度 ∇ f ( x ) \nabla f(\mathbf{x}) ∇ f ( x ) 的近似估计 ∇ ^ f ( x ) \hat{\nabla} f(\mathbf{x}) ∇ ^ f ( x )

如图所示:

左侧 (FO):优化器可直接访问白盒模型 f f f 右侧 (ZOO):优化器面对的是一个黑盒模型,只能通过“试探-反馈”(query-and-response)的方式间接推断函数的局部几何结构。

2.3 平滑函数 f r ( x ) f_r(\mathbf{x}) f r ( x ) r r r

由于无法直接获取 ∇ f ( x ) \nabla f(\mathbf{x}) ∇ f ( x ) 平滑版本 (smoothed version)函数 f r ( x ) f_r(\mathbf{x}) f r ( x )

f r ( x ) : = E u ∼ U [ f ( x + r u ) ] , f_r(\mathbf{x}) := \mathbb{E}_{\mathbf{u} \sim \mathcal{U}} \left[ f(\mathbf{x} + r \mathbf{u}) \right],

f r ( x ) := E u ∼ U [ f ( x + r u ) ] ,

其中 U \mathcal{U} U 各向同性 (isotropic)的随机扰动分布(见 2.4 节),r > 0 r > 0 r > 0 平滑半径 (Smoothing Radius)。

平滑半径 r r r 的作用 :

控制偏差 :f r ( x ) f_r(\mathbf{x}) f r ( x ) f ( x ) f(\mathbf{x}) f ( x ) ∇ f r ( x ) \nabla f_r(\mathbf{x}) ∇ f r ( x ) ∇ f ( x ) \nabla f(\mathbf{x}) ∇ f ( x ) r r r 引入正则性 :即使 f f f f r f_r f r 权衡方差 :在实践中,过小的 r r r r r r 偏差-方差 (bias-variance tradeoff)。

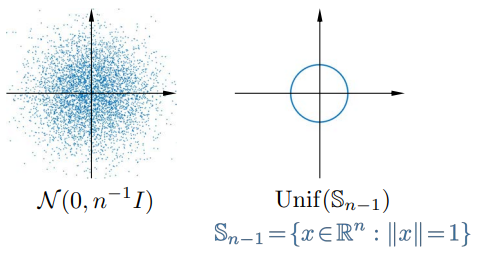

2.4 各向同性扰动分布

为了构造无偏的梯度估计器,扰动向量 u \mathbf{u} u 各向同性分布 ,即满足:

E [ u ] = 0 , E [ u u ⊤ ] = 1 p I . \mathbb{E}[\mathbf{u}] = \mathbf{0}, \quad \mathbb{E}[\mathbf{u} \mathbf{u}^\top] = \frac{1}{p} \mathbf{I}.

E [ u ] = 0 , E [ u u ⊤ ] = p 1 I .

常用的两种分布是:

高斯分布 N ( 0 , p − 1 I ) \mathcal{N}(\mathbf{0}, p^{-1} \mathbf{I}) N ( 0 , p − 1 I )

优点 :各分量独立,易于并行采样。缺点 :无界支撑集,在有界可行域上可能产生无效查询。

单位球面均匀分布 U n i f ( S p − 1 ) \mathrm{Unif}(\mathbb{S}^{p-1}) Unif ( S p − 1 )

优点 :∥ u ∥ = 1 \|\mathbf{u}\| = 1 ∥ u ∥ = 1 性质 :其协方差矩阵为 1 p I \frac{1}{p} \mathbf{I} p 1 I ∑ i = 1 p E [ u i 2 ] = 1 \sum_{i=1}^p \mathbb{E}[u_i^2] = 1 ∑ i = 1 p E [ u i 2 ] = 1 生成方法 :若 z ∼ N ( 0 , I ) \mathbf{z} \sim \mathcal{N}(\mathbf{0}, \mathbf{I}) z ∼ N ( 0 , I ) u = z / ∥ z ∥ ∼ U n i f ( S p − 1 ) \mathbf{u} = \mathbf{z} / \|\mathbf{z}\| \sim \mathrm{Unif}(\mathbb{S}^{p-1}) u = z /∥ z ∥ ∼ Unif ( S p − 1 )

这两种分布是构建后续所有梯度估计器 (单点、两点、坐标)的基石。

三、零阶优化中的梯度估计方法

3.1 单点零阶梯度估计(Single-Point Estimator)

我们从以下单点零阶梯度估计器 (single-point zeroth-order gradient estimator)开始:

G f ( x ; r , z ) = p r f ( x + r z ) z , z ∼ Z . (2) G_f(x; r, z) = \frac{p}{r} f(x + r z) z, \quad z \sim \mathcal{Z}. \tag{2}

G f ( x ; r , z ) = r p f ( x + rz ) z , z ∼ Z . ( 2 )

这里 r > 0 r > 0 r > 0 平滑半径 (smoothing radius);z z z Z \mathcal{Z} Z p p p 随机扰动 (random perturbation)。通常,Z \mathcal{Z} Z

高斯分布 :N ( 0 , p − 1 I ) \mathcal{N}(0, p^{-1} I) N ( 0 , p − 1 I )

p p p S p − 1 \mathbb{S}_{p-1} S p − 1 U ( S p − 1 ) \mathcal{U}(\mathbb{S}_{p-1}) U ( S p − 1 )

优点:变量的模长是固定的,对可行域有界的情况更加适用;

缺点:各分量相互依赖,不太容易分布式计算。

下面的引理描述了单点梯度估计器 (2) 的期望性质。

引理 1 . 假设 f : R p → R f: \mathbb{R}^p \to \mathbb{R} f : R p → R L L L

设 Z \mathcal{Z} Z N ( 0 , p − 1 I ) \mathcal{N}(0, p^{-1} I) N ( 0 , p − 1 I )

E z ∼ Z [ G f ( x ; r , z ) ] = ∇ f r ( x ) , \mathbb{E}_{z \sim \mathcal{Z}}[G_f(x; r, z)] = \nabla f_r(x),

E z ∼ Z [ G f ( x ; r , z )] = ∇ f r ( x ) ,

其中 f r : R p → R f_r: \mathbb{R}^p \to \mathbb{R} f r : R p → R

f r ( x ) : = E y ∼ Y [ f ( x + r y ) ] , f_r(x) := \mathbb{E}_{y \sim \mathcal{Y}}[f(x + r y)],

f r ( x ) := E y ∼ Y [ f ( x + ry )] ,

这里 Y \mathcal{Y} Y N ( 0 , p − 1 I ) \mathcal{N}(0, p^{-1} I) N ( 0 , p − 1 I )

设 Z \mathcal{Z} Z U n i f ( S p − 1 ) \mathrm{Unif}(\mathbb{S}_{p-1}) Unif ( S p − 1 )

E z ∼ Z [ G f ( x ; r , z ) ] = ∇ f r ( x ) , \mathbb{E}_{z \sim \mathcal{Z}}[G_f(x; r, z)] = \nabla f_r(x),

E z ∼ Z [ G f ( x ; r , z )] = ∇ f r ( x ) ,

其中 f r : R p → R f_r: \mathbb{R}^p \to \mathbb{R} f r : R p → R

f r ( x ) : = E y ∼ Y [ f ( x + r y ) ] , f_r(x) := \mathbb{E}_{y \sim \mathcal{Y}}[f(x + r y)],

f r ( x ) := E y ∼ Y [ f ( x + ry )] ,

这里 Y \mathcal{Y} Y B p : = { x ∈ R p : ∥ x ∥ ≤ 1 } \mathbb{B}_p := \{ x \in \mathbb{R}^p : \|x\| \leq 1 \} B p := { x ∈ R p : ∥ x ∥ ≤ 1 }

引理 1 表明,G f ( x ; r , z ) G_f(x; r, z) G f ( x ; r , z ) f f f f r f_r f r ∇ f r \nabla f_r ∇ f r

引理 2 . 假设 f f f L L L Z \mathcal{Z} Z N ( 0 , p − 1 I ) \mathcal{N}(0, p^{-1} I) N ( 0 , p − 1 I ) U n i f ( S p − 1 ) \mathrm{Unif}(\mathbb{S}_{p-1}) Unif ( S p − 1 ) f r f_r f r f f f f r f_r f r L L L

f ( x ) ≤ f r ( x ) ≤ f ( x ) + L r 2 2 , f(x) \leq f_r(x) \leq f(x) + \frac{L r^2}{2},

f ( x ) ≤ f r ( x ) ≤ f ( x ) + 2 L r 2 ,

以及

∥ ∇ f r ( x ) − ∇ f ( x ) ∥ ≤ L r . \|\nabla f_r(x) - \nabla f(x)\| \leq L r.

∥∇ f r ( x ) − ∇ f ( x ) ∥ ≤ L r .

证明:

首先,我们证明 f r f_r f r θ ∈ [ 0 , 1 ] \theta \in [0,1] θ ∈ [ 0 , 1 ] x 1 , x 2 ∈ R p x_1, x_2 \in \mathbb{R}^p x 1 , x 2 ∈ R p

f r ( θ x 1 + ( 1 − θ ) x 2 ) = E y ∼ Y [ f ( θ x 1 + ( 1 − θ ) x 2 + r y ) ] = E y ∼ Y [ f ( θ ( x 1 + r y ) + ( 1 − θ ) ( x 2 + r y ) ) ] ≤ E y ∼ Y [ θ f ( x 1 + r y ) + ( 1 − θ ) f ( x 2 + r y ) ] = θ E y ∼ Y [ f ( x 1 + r y ) ] + ( 1 − θ ) E y ∼ Y [ f ( x 2 + r y ) ] = θ f r ( x 1 ) + ( 1 − θ ) f r ( x 2 ) . \begin{aligned}

f_r(\theta x_1 + (1 - \theta) x_2)

&= \mathbb{E}_{y \sim \mathcal{Y}}[f(\theta x_1 + (1 - \theta) x_2 + r y)] \\

&= \mathbb{E}_{y \sim \mathcal{Y}}[f(\theta(x_1 + r y) + (1 - \theta)(x_2 + r y))] \\

&\leq \mathbb{E}_{y \sim \mathcal{Y}}[\theta f(x_1 + r y) + (1 - \theta) f(x_2 + r y)] \\

&= \theta \mathbb{E}_{y \sim \mathcal{Y}}[f(x_1 + r y)] + (1 - \theta) \mathbb{E}_{y \sim \mathcal{Y}}[f(x_2 + r y)] \\

&= \theta f_r(x_1) + (1 - \theta) f_r(x_2).

\end{aligned}

f r ( θ x 1 + ( 1 − θ ) x 2 ) = E y ∼ Y [ f ( θ x 1 + ( 1 − θ ) x 2 + ry )] = E y ∼ Y [ f ( θ ( x 1 + ry ) + ( 1 − θ ) ( x 2 + ry ))] ≤ E y ∼ Y [ θ f ( x 1 + ry ) + ( 1 − θ ) f ( x 2 + ry )] = θ E y ∼ Y [ f ( x 1 + ry )] + ( 1 − θ ) E y ∼ Y [ f ( x 2 + ry )] = θ f r ( x 1 ) + ( 1 − θ ) f r ( x 2 ) .

这表明 f r f_r f r

其次,我们证明 f r f_r f r L L L x 1 , x 2 ∈ R p x_1, x_2 \in \mathbb{R}^p x 1 , x 2 ∈ R p

∥ ∇ f r ( x 1 ) − ∇ f r ( x 2 ) ∥ = ∥ ∇ x E y ∼ Y [ f ( x 1 + r y ) ] − ∇ x E y ∼ Y [ f ( x 2 + r y ) ] ∥ = ∥ E y ∼ Y [ ∇ f ( x 1 + r y ) − ∇ f ( x 2 + r y ) ] ∥ ( 交换微分与期望 ) ≤ E y ∼ Y [ ∥ ∇ f ( x 1 + r y ) − ∇ f ( x 2 + r y ) ∥ ] ( Jensen 不等式 ) ≤ E y ∼ Y [ L ∥ x 1 − x 2 ∥ ] ( 由 f 的 L -光滑性 ) = L ∥ x 1 − x 2 ∥ . \begin{aligned}

\|\nabla f_r(x_1) - \nabla f_r(x_2)\|

&= \left\| \nabla_x \mathbb{E}_{y \sim \mathcal{Y}}[f(x_1 + r y)] - \nabla_x \mathbb{E}_{y \sim \mathcal{Y}}[f(x_2 + r y)] \right\| \\

&= \left\| \mathbb{E}_{y \sim \mathcal{Y}}[\nabla f(x_1 + r y) - \nabla f(x_2 + r y)] \right\| \quad (\text{交换微分与期望}) \\

&\leq \mathbb{E}_{y \sim \mathcal{Y}}[\|\nabla f(x_1 + r y) - \nabla f(x_2 + r y)\|] \quad (\text{Jensen 不等式}) \\

&\leq \mathbb{E}_{y \sim \mathcal{Y}}[L \|x_1 - x_2\|] \quad (\text{由 } f \text{ 的 } L\text{-光滑性}) \\

&= L \|x_1 - x_2\|.

\end{aligned}

∥∇ f r ( x 1 ) − ∇ f r ( x 2 ) ∥ = ∥ ∇ x E y ∼ Y [ f ( x 1 + ry )] − ∇ x E y ∼ Y [ f ( x 2 + ry )] ∥ = ∥ E y ∼ Y [ ∇ f ( x 1 + ry ) − ∇ f ( x 2 + ry )] ∥ ( 交换微分与期望 ) ≤ E y ∼ Y [ ∥∇ f ( x 1 + ry ) − ∇ f ( x 2 + ry ) ∥ ] ( Jensen 不等式 ) ≤ E y ∼ Y [ L ∥ x 1 − x 2 ∥ ] ( 由 f 的 L - 光滑性 ) = L ∥ x 1 − x 2 ∥.

因此,f r f_r f r L L L

接下来,我们证明第一个不等式 f ( x ) ≤ f r ( x ) ≤ f ( x ) + L r 2 2 f(x) \leq f_r(x) \leq f(x) + \frac{L r^2}{2} f ( x ) ≤ f r ( x ) ≤ f ( x ) + 2 L r 2 f f f L L L x , y x, y x , y

f ( x ) + ⟨ ∇ f ( x ) , r y ⟩ ≤ f ( x + r y ) ≤ f ( x ) + ⟨ ∇ f ( x ) , r y ⟩ + L 2 ∥ r y ∥ 2 . f(x) + \langle \nabla f(x), r y \rangle \leq f(x + r y) \leq f(x) + \langle \nabla f(x), r y \rangle + \frac{L}{2} \|r y\|^2.

f ( x ) + ⟨ ∇ f ( x ) , ry ⟩ ≤ f ( x + ry ) ≤ f ( x ) + ⟨ ∇ f ( x ) , ry ⟩ + 2 L ∥ ry ∥ 2 .

对上式两边关于 y ∼ Y y \sim \mathcal{Y} y ∼ Y Y \mathcal{Y} Y E y ∼ Y [ ⟨ ∇ f ( x ) , r y ⟩ ] = 0 \mathbb{E}_{y \sim \mathcal{Y}}[\langle \nabla f(x), r y \rangle] = 0 E y ∼ Y [⟨ ∇ f ( x ) , ry ⟩] = 0 E y ∼ Y [ ∥ y ∥ 2 ] = 1 \mathbb{E}_{y \sim \mathcal{Y}}[\|y\|^2] = 1 E y ∼ Y [ ∥ y ∥ 2 ] = 1

f ( x ) ≤ E y ∼ Y [ f ( x + r y ) ] ≤ f ( x ) + L r 2 2 . f(x) \leq \mathbb{E}_{y \sim \mathcal{Y}}[f(x + r y)] \leq f(x) + \frac{L r^2}{2}.

f ( x ) ≤ E y ∼ Y [ f ( x + ry )] ≤ f ( x ) + 2 L r 2 .

即 f ( x ) ≤ f r ( x ) ≤ f ( x ) + L r 2 2 f(x) \leq f_r(x) \leq f(x) + \frac{L r^2}{2} f ( x ) ≤ f r ( x ) ≤ f ( x ) + 2 L r 2

最后,我们证明第二个不等式 ∥ ∇ f r ( x ) − ∇ f ( x ) ∥ ≤ L r \|\nabla f_r(x) - \nabla f(x)\| \leq L r ∥∇ f r ( x ) − ∇ f ( x ) ∥ ≤ L r

∥ ∇ f r ( x ) − ∇ f ( x ) ∥ = ∥ ∇ x E y ∼ Y [ f ( x + r y ) ] − ∇ x f ( x ) ∥ = ∥ E y ∼ Y [ ∇ x f ( x + r y ) − ∇ x f ( x ) ] ∥ ( 交换微分与期望 ) ≤ E y ∼ Y [ ∥ ∇ f ( x + r y ) − ∇ f ( x ) ∥ ] ( Jensen 不等式 ) ≤ E y ∼ Y [ L ∥ r y ∥ ] ( 由 f 的 L -光滑性 ) ≤ L r ⋅ E y ∼ Y [ ∥ y ∥ ] ≤ L r ⋅ E y ∼ Y [ ∥ y ∥ 2 ] ( Jensen 不等式 ) = L r . \begin{aligned}

\|\nabla f_r(x) - \nabla f(x)\|

&= \left\| \nabla_x \mathbb{E}_{y \sim \mathcal{Y}}[f(x + r y)] - \nabla_x f(x) \right\| \\

&= \left\| \mathbb{E}_{y \sim \mathcal{Y}}[\nabla_x f(x + r y) - \nabla_x f(x)] \right\| \quad (\text{交换微分与期望}) \\

&\leq \mathbb{E}_{y \sim \mathcal{Y}}[\|\nabla f(x + r y) - \nabla f(x)\|] \quad (\text{Jensen 不等式}) \\

&\leq \mathbb{E}_{y \sim \mathcal{Y}}[L \|r y\|] \quad (\text{由 } f \text{ 的 } L\text{-光滑性}) \\

&\leq L r \cdot \mathbb{E}_{y \sim \mathcal{Y}}[\|y\|] \\

&\leq L r \cdot \sqrt{\mathbb{E}_{y \sim \mathcal{Y}}[\|y\|^2]} \quad (\text{Jensen 不等式}) \\

&= L r.

\end{aligned}

∥∇ f r ( x ) − ∇ f ( x ) ∥ = ∥ ∇ x E y ∼ Y [ f ( x + ry )] − ∇ x f ( x ) ∥ = ∥ E y ∼ Y [ ∇ x f ( x + ry ) − ∇ x f ( x )] ∥ ( 交换微分与期望 ) ≤ E y ∼ Y [ ∥∇ f ( x + ry ) − ∇ f ( x ) ∥ ] ( Jensen 不等式 ) ≤ E y ∼ Y [ L ∥ ry ∥ ] ( 由 f 的 L - 光滑性 ) ≤ L r ⋅ E y ∼ Y [ ∥ y ∥ ] ≤ L r ⋅ E y ∼ Y [ ∥ y ∥ 2 ] ( Jensen 不等式 ) = L r .

这里,我们使用了 E [ ∥ y ∥ ] ≤ E [ ∥ y ∥ 2 ] = 1 \mathbb{E}[\|y\|] \leq \sqrt{\mathbb{E}[\|y\|^2]} = 1 E [ ∥ y ∥ ] ≤ E [ ∥ y ∥ 2 ] = 1 ∥ ∇ f r ( x ) − ∇ f ( x ) ∥ ≤ L r \|\nabla f_r(x) - \nabla f(x)\| \leq L r ∥∇ f r ( x ) − ∇ f ( x ) ∥ ≤ L r

引理 2 限定了 f r − f f_r - f f r − f ∇ f r − ∇ f \nabla f_r - \nabla f ∇ f r − ∇ f r → 0 r \to 0 r → 0 G f ( x ; r , z ) G_f(x; r, z) G f ( x ; r , z ) f f f r r r

方差(二阶矩)分析

我们考虑 Z = U n i f ( S p − 1 ) \mathcal{Z} = \mathrm{Unif}(\mathbb{S}^{p-1}) Z = Unif ( S p − 1 )

利用泰勒展开:

f ( x + r z ) = f ( x ) + ⟨ ∇ f ( x ) , r z ⟩ + 1 2 r 2 z ⊤ ∇ 2 f ( ξ ) z , f(\mathbf{x} + r\mathbf{z}) = f(\mathbf{x}) + \langle \nabla f(\mathbf{x}), r\mathbf{z} \rangle + \frac{1}{2} r^2 \mathbf{z}^\top \nabla^2 f(\xi) \mathbf{z},

f ( x + r z ) = f ( x ) + ⟨ ∇ f ( x ) , r z ⟩ + 2 1 r 2 z ⊤ ∇ 2 f ( ξ ) z ,

其中 ξ \xi ξ x \mathbf{x} x x + r z \mathbf{x}+r\mathbf{z} x + r z

代入估计器得:

G f ( 1 ) = p r f ( x ) z + p ⟨ ∇ f ( x ) , z ⟩ z + p r 2 z ⊤ ∇ 2 f ( ξ ) z ⋅ z . G_f^{(1)} = \frac{p}{r} f(\mathbf{x}) \mathbf{z} + p \langle \nabla f(\mathbf{x}), \mathbf{z} \rangle \mathbf{z} + \frac{p r}{2} \mathbf{z}^\top \nabla^2 f(\xi) \mathbf{z} \cdot \mathbf{z}.

G f ( 1 ) = r p f ( x ) z + p ⟨ ∇ f ( x ) , z ⟩ z + 2 p r z ⊤ ∇ 2 f ( ξ ) z ⋅ z .

由于 E [ z ] = 0 \mathbb{E}[\mathbf{z}] = \mathbf{0} E [ z ] = 0 其二阶矩包含常数项 f ( x ) 2 f(\mathbf{x})^2 f ( x ) 2

E [ ∥ G f ( 1 ) ∥ 2 ] = p 2 r 2 E [ f ( x + r z ) 2 ∥ z ∥ 2 ] = p 2 r 2 E [ f ( x + r z ) 2 ] ( 因 ∥ z ∥ = 1 ) ≥ p 2 r 2 ( E [ f ( x + r z ) ] ) 2 = p 2 r 2 f r ( x ) 2 . \begin{aligned}

\mathbb{E}\left[ \|G_f^{(1)}\|^2 \right]

&= \frac{p^2}{r^2} \mathbb{E}\left[ f(\mathbf{x} + r\mathbf{z})^2 \|\mathbf{z}\|^2 \right] \\

&= \frac{p^2}{r^2} \mathbb{E}\left[ f(\mathbf{x} + r\mathbf{z})^2 \right] \quad (\text{因 }\|\mathbf{z}\|=1) \\

&\geq \frac{p^2}{r^2} \left( \mathbb{E}[f(\mathbf{x} + r\mathbf{z})] \right)^2 = \frac{p^2}{r^2} f_r(\mathbf{x})^2.

\end{aligned}

E [ ∥ G f ( 1 ) ∥ 2 ] = r 2 p 2 E [ f ( x + r z ) 2 ∥ z ∥ 2 ] = r 2 p 2 E [ f ( x + r z ) 2 ] ( 因 ∥ z ∥ = 1 ) ≥ r 2 p 2 ( E [ f ( x + r z )] ) 2 = r 2 p 2 f r ( x ) 2 .

即使 f ( x ) f(\mathbf{x}) f ( x ) ∣ f ( x ) ∣ ≤ M |f(\mathbf{x})| \leq M ∣ f ( x ) ∣ ≤ M

E [ ∥ G f ( 1 ) ∥ 2 ] ≥ p 2 r 2 ( f ( x ) − L r 2 / 2 ) 2 = Ω ( 1 r 2 ) . \mathbb{E}\left[ \|G_f^{(1)}\|^2 \right] \geq \frac{p^2}{r^2} (f(\mathbf{x}) - Lr^2/2)^2 = \Omega\left( \frac{1}{r^2} \right).

E [ ∥ G f ( 1 ) ∥ 2 ] ≥ r 2 p 2 ( f ( x ) − L r 2 /2 ) 2 = Ω ( r 2 1 ) .

关键结论 :单点估计器的二阶矩下界为 Ω ( r − 2 ) \Omega(r^{-2}) Ω ( r − 2 ) 当 r → 0 r \to 0 r → 0 时,方差爆炸 ,导致梯度估计噪声极大,无法保证收敛 。

相比之下,两点估计器的方差有界,故单点方法仅用于理论分析,实践中不可行 。

收敛性分析

考虑基于单点估计器的 ZO-SGD 迭代:

x k + 1 = x k − α k G f ( 1 ) ( x k ; r k , z k ) . \mathbf{x}_{k+1} = \mathbf{x}_k - \alpha_k G_f^{(1)}(\mathbf{x}_k; r_k, \mathbf{z}_k).

x k + 1 = x k − α k G f ( 1 ) ( x k ; r k , z k ) .

展开误差:

E [ ∥ x k + 1 − x ∗ ∥ 2 ∣ F k ] = ∥ x k − x ∗ ∥ 2 − 2 α k ⟨ x k − x ∗ , ∇ f r k ( x k ) ⟩ + α k 2 E [ ∥ G f ( 1 ) ∥ 2 ∣ F k ] . \begin{aligned}

\mathbb{E}[\|\mathbf{x}_{k+1} - \mathbf{x}^*\|^2 \mid \mathcal{F}_k]

&= \|\mathbf{x}_k - \mathbf{x}^*\|^2 - 2\alpha_k \langle \mathbf{x}_k - \mathbf{x}^*, \nabla f_{r_k}(\mathbf{x}_k) \rangle \\

&\quad + \alpha_k^2 \mathbb{E}[\|G_f^{(1)}\|^2 \mid \mathcal{F}_k].

\end{aligned}

E [ ∥ x k + 1 − x ∗ ∥ 2 ∣ F k ] = ∥ x k − x ∗ ∥ 2 − 2 α k ⟨ x k − x ∗ , ∇ f r k ( x k )⟩ + α k 2 E [ ∥ G f ( 1 ) ∥ 2 ∣ F k ] .

前两项与两点估计器相同,但第三项 (方差项):

α k 2 E [ ∥ G f ( 1 ) ∥ 2 ] ≥ α k 2 ⋅ c p 2 r k 2 , \alpha_k^2 \mathbb{E}[\|G_f^{(1)}\|^2] \geq \alpha_k^2 \cdot \frac{c p^2}{r_k^2},

α k 2 E [ ∥ G f ( 1 ) ∥ 2 ] ≥ α k 2 ⋅ r k 2 c p 2 ,

其中 c > 0 c > 0 c > 0

为使偏差可控,需 r k → 0 r_k \to 0 r k → 0 r k = 1 / k r_k = 1/\sqrt{k} r k = 1/ k ∝ α k 2 k \propto \alpha_k^2 k ∝ α k 2 k α k = 1 / k \alpha_k = 1/k α k = 1/ k O ( 1 / k ) \mathcal{O}(1/k) O ( 1/ k ) 无法被前两项的 − O ( 1 / k ) - \mathcal{O}(1/k) − O ( 1/ k ) 抵消 ,导致:

∑ k = 0 ∞ α k 2 E [ ∥ G f ( 1 ) ∥ 2 ] = ∞ , \sum_{k=0}^\infty \alpha_k^2 \mathbb{E}[\|G_f^{(1)}\|^2] = \infty,

k = 0 ∑ ∞ α k 2 E [ ∥ G f ( 1 ) ∥ 2 ] = ∞ ,

迭代序列不收敛 。

结论 (Nesterov & Spokoiny, 2017)无法在一般光滑凸函数上保证收敛 ,除非对函数施加额外假设(如 f ( x ∗ ) = 0 f(\mathbf{x}^*) = 0 f ( x ∗ ) = 0

3.2 两点梯度估计器 (Two-Point Gradient Estimators)

单点梯度估计器提供了一个具有非零但可控偏差的随机梯度。然而,其方差(或二阶矩)大致为 r − 2 r^{-2} r − 2 两点零阶梯度估计器 (two-point zeroth-order gradient estimators),它利用两个函数值来降低方差。

存在两种版本的两点梯度估计器:

G f ( 2 ) ( x ; r , z ) = p r ( f ( x + r z ) − f ( x ) ) z , G_f^{(2)}(x; r, z) = \frac{p}{r} \big( f(x + rz) - f(x) \big) z,

G f ( 2 ) ( x ; r , z ) = r p ( f ( x + rz ) − f ( x ) ) z ,

和

G ~ f ( 2 ) ( x ; r , z ) = p 2 r ( f ( x + r z ) − f ( x − r z ) ) z , \tilde{G}_f^{(2)}(x; r, z) = \frac{p}{2r} \big( f(x + rz) - f(x - rz) \big) z,

G ~ f ( 2 ) ( x ; r , z ) = 2 r p ( f ( x + rz ) − f ( x − rz ) ) z ,

其中 z ∼ Z z \sim \mathcal{Z} z ∼ Z Z \mathcal{Z} Z U n i f ( S p − 1 ) \mathrm{Unif}(\mathbb{S}_{p-1}) Unif ( S p − 1 ) N ( 0 , p − 1 I ) \mathcal{N}(0, p^{-1} I) N ( 0 , p − 1 I )

由于 Z \mathcal{Z} Z G f ( 2 ) ( x ; r , z ) G_f^{(2)}(x; r, z) G f ( 2 ) ( x ; r , z ) G ~ f ( 2 ) ( x ; r , z ) \tilde{G}_f^{(2)}(x; r, z) G ~ f ( 2 ) ( x ; r , z )

E z ∼ Z [ G f ( 2 ) ( x ; r , z ) ] = E z ∼ Z [ G ~ f ( 2 ) ( x ; r , z ) ] = ∇ f r ( x ) . \mathbb{E}_{z \sim \mathcal{Z}}[G_f^{(2)}(x; r, z)] = \mathbb{E}_{z \sim \mathcal{Z}}[\tilde{G}_f^{(2)}(x; r, z)] = \nabla f_r(x).

E z ∼ Z [ G f ( 2 ) ( x ; r , z )] = E z ∼ Z [ G ~ f ( 2 ) ( x ; r , z )] = ∇ f r ( x ) .

另一方面,以下引理表明,它们的二阶矩对平滑半径 r r r

引理 3 . 假设 f f f L L L Z \mathcal{Z} Z N ( 0 , p − 1 I ) \mathcal{N}(0, p^{-1} I) N ( 0 , p − 1 I ) U n i f ( S p − 1 ) \mathrm{Unif}(\mathbb{S}_{p-1}) Unif ( S p − 1 )

E z ∼ Z [ ∥ G f ( 2 ) ( x ; r , z ) ∥ 2 ] ≤ { 2 ( p + 2 ) ∥ ∇ f ( x ) ∥ 2 + r 2 L 2 p 2 2 ( p + 6 p ) 3 , Z 为 N ( 0 , p − 1 I ) , 2 p ∥ ∇ f ( x ) ∥ 2 + r 2 L 2 p 2 2 , Z 为 U n i f ( S p − 1 ) . \mathbb{E}_{z \sim \mathcal{Z}}\left[ \left\| G_f^{(2)}(x; r, z) \right\|^2 \right] \leq

\begin{cases}

2(p+2) \|\nabla f(x)\|^2 + \dfrac{r^2 L^2 p^2}{2} \left( \dfrac{p+6}{p} \right)^3, & \mathcal{Z} \text{ 为 } \mathcal{N}(0, p^{-1} I), \\

2p \|\nabla f(x)\|^2 + \dfrac{r^2 L^2 p^2}{2}, & \mathcal{Z} \text{ 为 } \mathrm{Unif}(\mathbb{S}_{p-1}).

\end{cases}

E z ∼ Z [ G f ( 2 ) ( x ; r , z ) 2 ] ≤ ⎩ ⎨ ⎧ 2 ( p + 2 ) ∥∇ f ( x ) ∥ 2 + 2 r 2 L 2 p 2 ( p p + 6 ) 3 , 2 p ∥∇ f ( x ) ∥ 2 + 2 r 2 L 2 p 2 , Z 为 N ( 0 , p − 1 I ) , Z 为 Unif ( S p − 1 ) .

并且对 E z ∼ Z [ ∥ G ~ f ( 2 ) ( x ; r , z ) ∥ 2 ] \mathbb{E}_{z \sim \mathcal{Z}}\left[ \left\| \tilde{G}_f^{(2)}(x; r, z) \right\|^2 \right] E z ∼ Z [ G ~ f ( 2 ) ( x ; r , z ) 2 ]

证明 .

我们仅给出 G f ( 2 ) ( x ; r , z ) G_f^{(2)}(x; r, z) G f ( 2 ) ( x ; r , z )

我们有:

E z [ ∥ G f ( 2 ) ( x ; r , z ) ∥ 2 ] = p 2 r 2 E z [ ∣ f ( x + r z ) − f ( x ) ∣ 2 ⋅ ∥ z ∥ 2 ] ≤ p 2 r 2 E z [ ( 2 ∣ f ( x + r z ) − f ( x ) − ⟨ ∇ f ( x ) , r z ⟩ ∣ 2 + 2 ∣ ⟨ ∇ f ( x ) , r z ⟩ ∣ 2 ) ∥ z ∥ 2 ] = 2 p 2 r 2 E z [ ∣ f ( x + r z ) − f ( x ) − ⟨ ∇ f ( x ) , r z ⟩ ∣ 2 ∥ z ∥ 2 ] + 2 p 2 E z [ ∣ ⟨ ∇ f ( x ) , z ⟩ ∣ 2 ∥ z ∥ 2 ] . ( 3 ) \begin{aligned}

\mathbb{E}_{z}\left[ \left\| G_f^{(2)}(x; r, z) \right\|^2 \right]

&= \frac{p^2}{r^2} \mathbb{E}_{z}\left[ \left| f(x + rz) - f(x) \right|^2 \cdot \|z\|^2 \right] \\

&\leq \frac{p^2}{r^2} \mathbb{E}_{z}\left[ \left( 2 \left| f(x + rz) - f(x) - \langle \nabla f(x), rz \rangle \right|^2 + 2 \left| \langle \nabla f(x), rz \rangle \right|^2 \right) \|z\|^2 \right] \\

&= \frac{2p^2}{r^2} \mathbb{E}_{z}\left[ \left| f(x + rz) - f(x) - \langle \nabla f(x), rz \rangle \right|^2 \|z\|^2 \right] + 2p^2 \mathbb{E}_{z}\left[ \left| \langle \nabla f(x), z \rangle \right|^2 \|z\|^2 \right]. \quad (3)

\end{aligned}

E z [ G f ( 2 ) ( x ; r , z ) 2 ] = r 2 p 2 E z [ ∣ f ( x + rz ) − f ( x ) ∣ 2 ⋅ ∥ z ∥ 2 ] ≤ r 2 p 2 E z [ ( 2 ∣ f ( x + rz ) − f ( x ) − ⟨ ∇ f ( x ) , rz ⟩ ∣ 2 + 2 ∣ ⟨ ∇ f ( x ) , rz ⟩ ∣ 2 ) ∥ z ∥ 2 ] = r 2 2 p 2 E z [ ∣ f ( x + rz ) − f ( x ) − ⟨ ∇ f ( x ) , rz ⟩ ∣ 2 ∥ z ∥ 2 ] + 2 p 2 E z [ ∣ ⟨ ∇ f ( x ) , z ⟩ ∣ 2 ∥ z ∥ 2 ] . ( 3 )

首先,我们考虑式 (3) 中的第二项。注意到:

E z [ ∣ ⟨ ∇ f ( x ) , z ⟩ ∣ 2 ⋅ ∥ z ∥ 2 ] = ( ∇ f ( x ) ) ⊤ E z [ ∥ z ∥ 2 z z ⊤ ] ∇ f ( x ) . \mathbb{E}_{z}\left[ \left| \langle \nabla f(x), z \rangle \right|^2 \cdot \|z\|^2 \right] = (\nabla f(x))^\top \mathbb{E}_{z}\left[ \|z\|^2 z z^\top \right] \nabla f(x).

E z [ ∣ ⟨ ∇ f ( x ) , z ⟩ ∣ 2 ⋅ ∥ z ∥ 2 ] = ( ∇ f ( x ) ) ⊤ E z [ ∥ z ∥ 2 z z ⊤ ] ∇ f ( x ) .

如果 Z \mathcal{Z} Z N ( 0 , p − 1 I ) \mathcal{N}(0, p^{-1} I) N ( 0 , p − 1 I )

E z [ ∥ z ∥ 2 z i z j ] = ∑ k = 1 p E z [ z k 2 z i z j ] = { p + 2 p 2 , i = j , 0 , i ≠ j . \mathbb{E}_{z}\left[ \|z\|^2 z_i z_j \right] = \sum_{k=1}^p \mathbb{E}_{z}\left[ z_k^2 z_i z_j \right] =

\begin{cases}

\dfrac{p+2}{p^2}, & i = j, \\

0, & i \neq j.

\end{cases}

E z [ ∥ z ∥ 2 z i z j ] = k = 1 ∑ p E z [ z k 2 z i z j ] = ⎩ ⎨ ⎧ p 2 p + 2 , 0 , i = j , i = j .

这里用到了高斯分布 N ( 0 , 1 / p ) \mathcal{N}(0, 1/p) N ( 0 , 1/ p ) E [ z i 4 ] = 3 / p 2 \mathbb{E}[z_i^4] = 3/p^2 E [ z i 4 ] = 3/ p 2

E z [ ∥ z ∥ 2 z z ⊤ ] = p + 2 p 2 I . \mathbb{E}_{z}\left[ \|z\|^2 z z^\top \right] = \frac{p+2}{p^2} I.

E z [ ∥ z ∥ 2 z z ⊤ ] = p 2 p + 2 I .

如果 Z \mathcal{Z} Z U n i f ( S p − 1 ) \mathrm{Unif}(\mathbb{S}_{p-1}) Unif ( S p − 1 )

E z [ ∥ z ∥ 2 z z ⊤ ] = E z [ z z ⊤ ] = 1 p I , \mathbb{E}_{z}\left[ \|z\|^2 z z^\top \right] = \mathbb{E}_{z}\left[ z z^\top \right] = \frac{1}{p} I,

E z [ ∥ z ∥ 2 z z ⊤ ] = E z [ z z ⊤ ] = p 1 I ,

这里用到了由对称性可得 E z [ z i z j ] = 0 \mathbb{E}_{z}[z_i z_j] = 0 E z [ z i z j ] = 0 i ≠ j i \neq j i = j

因此,第二项满足:

2 p 2 E z [ ∣ ⟨ ∇ f ( x ) , z ⟩ ∣ 2 ⋅ ∥ z ∥ 2 ] = { 2 ( p + 2 ) ∥ ∇ f ( x ) ∥ 2 , Z 为 N ( 0 , p − 1 I ) , 2 p ∥ ∇ f ( x ) ∥ 2 , Z 为 U n i f ( S p − 1 ) . 2p^2 \mathbb{E}_{z}\left[ \left| \langle \nabla f(x), z \rangle \right|^2 \cdot \|z\|^2 \right] =

\begin{cases}

2(p+2) \|\nabla f(x)\|^2, & \mathcal{Z} \text{ 为 } \mathcal{N}(0, p^{-1} I), \\

2p \|\nabla f(x)\|^2, & \mathcal{Z} \text{ 为 } \mathrm{Unif}(\mathbb{S}_{p-1}).

\end{cases}

2 p 2 E z [ ∣ ⟨ ∇ f ( x ) , z ⟩ ∣ 2 ⋅ ∥ z ∥ 2 ] = { 2 ( p + 2 ) ∥∇ f ( x ) ∥ 2 , 2 p ∥∇ f ( x ) ∥ 2 , Z 为 N ( 0 , p − 1 I ) , Z 为 Unif ( S p − 1 ) .

接下来,我们界定第一项。根据牛顿-莱布尼茨定理(Newton-Leibniz theorem):

f ( x + r z ) − f ( x ) = ∫ 0 r ⟨ ∇ f ( x + t z ) , z ⟩ d t , f(x + rz) - f(x) = \int_0^r \langle \nabla f(x + tz), z \rangle dt,

f ( x + rz ) − f ( x ) = ∫ 0 r ⟨ ∇ f ( x + t z ) , z ⟩ d t ,

因此,

∣ f ( x + r z ) − f ( x ) − ⟨ ∇ f ( x ) , r z ⟩ ∣ = ∣ ∫ 0 r ⟨ ∇ f ( x + t z ) − ∇ f ( x ) , z ⟩ d t ∣ ≤ ∫ 0 r ∥ ∇ f ( x + t z ) − ∇ f ( x ) ∥ ∥ z ∥ d t ≤ ∫ 0 r L t ∥ z ∥ 2 d t = L r 2 2 ∥ z ∥ 2 . \begin{aligned}

\left| f(x + rz) - f(x) - \langle \nabla f(x), rz \rangle \right|

&= \left| \int_0^r \langle \nabla f(x + tz) - \nabla f(x), z \rangle dt \right| \\

&\leq \int_0^r \| \nabla f(x + tz) - \nabla f(x) \| \|z\| dt \\

&\leq \int_0^r Lt \|z\|^2 dt = \frac{Lr^2}{2} \|z\|^2.

\end{aligned}

∣ f ( x + rz ) − f ( x ) − ⟨ ∇ f ( x ) , rz ⟩ ∣ = ∫ 0 r ⟨ ∇ f ( x + t z ) − ∇ f ( x ) , z ⟩ d t ≤ ∫ 0 r ∥∇ f ( x + t z ) − ∇ f ( x ) ∥∥ z ∥ d t ≤ ∫ 0 r L t ∥ z ∥ 2 d t = 2 L r 2 ∥ z ∥ 2 .

我们进而得到:

2 p 2 r 2 E z [ ∣ f ( x + r z ) − f ( x ) − ⟨ ∇ f ( x ) , r z ⟩ ∣ 2 ∥ z ∥ 2 ] ≤ 2 p 2 r 2 E z [ ( L r 2 2 ∥ z ∥ 2 ) 2 ∥ z ∥ 2 ] = 2 p 2 r 2 ⋅ L 2 r 4 4 E z [ ∥ z ∥ 6 ] ≤ { ( p + 6 ) 3 p 3 ⋅ r 2 L 2 p 2 2 , Z 为 N ( 0 , p − 1 I ) , r 2 L 2 p 2 2 , Z 为 U n i f ( S p − 1 ) . \begin{aligned}

\frac{2p^2}{r^2} \mathbb{E}_{z}\left[ \left| f(x + rz) - f(x) - \langle \nabla f(x), rz \rangle \right|^2 \|z\|^2 \right]

&\leq \frac{2p^2}{r^2} \mathbb{E}_{z}\left[ \left( \frac{Lr^2}{2} \|z\|^2 \right)^2 \|z\|^2 \right] \\

&= \frac{2p^2}{r^2} \cdot \frac{L^2 r^4}{4} \mathbb{E}_{z}\left[ \|z\|^6 \right] \\

&\leq

\begin{cases}

\dfrac{(p+6)^3}{p^3} \cdot \dfrac{r^2 L^2 p^2}{2}, & \mathcal{Z} \text{ 为 } \mathcal{N}(0, p^{-1} I), \\

\dfrac{r^2 L^2 p^2}{2}, & \mathcal{Z} \text{ 为 } \mathrm{Unif}(\mathbb{S}_{p-1}).

\end{cases}

\end{aligned}

r 2 2 p 2 E z [ ∣ f ( x + rz ) − f ( x ) − ⟨ ∇ f ( x ) , rz ⟩ ∣ 2 ∥ z ∥ 2 ] ≤ r 2 2 p 2 E z [ ( 2 L r 2 ∥ z ∥ 2 ) 2 ∥ z ∥ 2 ] = r 2 2 p 2 ⋅ 4 L 2 r 4 E z [ ∥ z ∥ 6 ] ≤ ⎩ ⎨ ⎧ p 3 ( p + 6 ) 3 ⋅ 2 r 2 L 2 p 2 , 2 r 2 L 2 p 2 , Z 为 N ( 0 , p − 1 I ) , Z 为 Unif ( S p − 1 ) .

这里用到了对于 z ∼ N ( 0 , p − 1 I ) z \sim \mathcal{N}(0, p^{-1} I) z ∼ N ( 0 , p − 1 I ) E [ ∥ z ∥ 6 ] ≤ ( p + 6 ) 3 / p 3 \mathbb{E}[\|z\|^6] \leq (p+6)^3 / p^3 E [ ∥ z ∥ 6 ] ≤ ( p + 6 ) 3 / p 3

综上,结合两项结果,即得引理 3 的结论。以上证明展示了方差上界的详细推导。下面,我们从一个更直观的角度来理解这个结果。

方差(二阶矩)分析

关键在于控制 E [ ∥ G ~ f ( 2 ) ∥ 2 ] \mathbb{E}[\|\tilde{G}_f^{(2)}\|^2] E [ ∥ G ~ f ( 2 ) ∥ 2 ]

E z [ ∥ G ~ f ( 2 ) ( x ; r , z ) ∥ 2 ] = p 2 4 r 2 E z [ ∣ f ( x + r z ) − f ( x − r z ) ∣ 2 ∥ z ∥ 2 ] ≤ p 2 4 r 2 E z [ ( 2 ⟨ ∇ f ( x ) , 2 r z ⟩ + L r 2 ∥ z ∥ 2 ) 2 ∥ z ∥ 2 ] ≤ 2 p 2 E z [ ⟨ ∇ f ( x ) , z ⟩ 2 ∥ z ∥ 2 ] + p 2 L 2 r 2 2 E z [ ∥ z ∥ 6 ] . \begin{aligned}

\mathbb{E}_{\mathbf{z}}\left[ \left\| \tilde{G}_f^{(2)}(\mathbf{x}; r, \mathbf{z}) \right\|^2 \right]

&= \frac{p^2}{4r^2} \mathbb{E}_{\mathbf{z}}\left[ \left| f(\mathbf{x}+r\mathbf{z}) - f(\mathbf{x}-r\mathbf{z}) \right|^2 \|\mathbf{z}\|^2 \right] \\

&\leq \frac{p^2}{4r^2} \mathbb{E}_{\mathbf{z}}\left[ \left( 2 \langle \nabla f(\mathbf{x}), 2r\mathbf{z} \rangle + L r^2 \|\mathbf{z}\|^2 \right)^2 \|\mathbf{z}\|^2 \right] \\

&\leq 2p^2 \mathbb{E}_{\mathbf{z}}\left[ \langle \nabla f(\mathbf{x}), \mathbf{z} \rangle^2 \|\mathbf{z}\|^2 \right] + \frac{p^2 L^2 r^2}{2} \mathbb{E}_{\mathbf{z}}[\|\mathbf{z}\|^6].

\end{aligned}

E z [ G ~ f ( 2 ) ( x ; r , z ) 2 ] = 4 r 2 p 2 E z [ ∣ f ( x + r z ) − f ( x − r z ) ∣ 2 ∥ z ∥ 2 ] ≤ 4 r 2 p 2 E z [ ( 2 ⟨ ∇ f ( x ) , 2 r z ⟩ + L r 2 ∥ z ∥ 2 ) 2 ∥ z ∥ 2 ] ≤ 2 p 2 E z [ ⟨ ∇ f ( x ) , z ⟩ 2 ∥ z ∥ 2 ] + 2 p 2 L 2 r 2 E z [ ∥ z ∥ 6 ] .

项1 :E [ ⟨ ∇ f , z ⟩ 2 ∥ z ∥ 2 ] = ( ∇ f ) ⊤ E [ ∥ z ∥ 2 z z ⊤ ] ∇ f \mathbb{E}[\langle \nabla f, \mathbf{z} \rangle^2 \|\mathbf{z}\|^2] = (\nabla f)^\top \mathbb{E}[\|\mathbf{z}\|^2 \mathbf{z} \mathbf{z}^\top] \nabla f E [⟨ ∇ f , z ⟩ 2 ∥ z ∥ 2 ] = ( ∇ f ) ⊤ E [ ∥ z ∥ 2 z z ⊤ ] ∇ f

若 Z = U n i f ( S p − 1 ) \mathcal{Z} = \mathrm{Unif}(\mathbb{S}^{p-1}) Z = Unif ( S p − 1 ) ∥ z ∥ = 1 \|\mathbf{z}\| = 1 ∥ z ∥ = 1 E [ z z ⊤ ] = 1 p I \mathbb{E}[\mathbf{z}\mathbf{z}^\top] = \frac{1}{p} \mathbf{I} E [ z z ⊤ ] = p 1 I 1 p ∥ ∇ f ∥ 2 \frac{1}{p} \|\nabla f\|^2 p 1 ∥∇ f ∥ 2

若 Z = N ( 0 , p − 1 I ) \mathcal{Z} = \mathcal{N}(\mathbf{0}, p^{-1}\mathbf{I}) Z = N ( 0 , p − 1 I ) E [ ∥ z ∥ 2 z z ⊤ ] = p + 2 p 2 I \mathbb{E}[\|\mathbf{z}\|^2 \mathbf{z}\mathbf{z}^\top] = \frac{p+2}{p^2} \mathbf{I} E [ ∥ z ∥ 2 z z ⊤ ] = p 2 p + 2 I

项2 :E [ ∥ z ∥ 6 ] \mathbb{E}[\|\mathbf{z}\|^6] E [ ∥ z ∥ 6 ] O ( 1 ) \mathcal{O}(1) O ( 1 )

最终可得(以 Z = U n i f ( S p − 1 ) \mathcal{Z} = \mathrm{Unif}(\mathbb{S}^{p-1}) Z = Unif ( S p − 1 )

E [ ∥ G ~ f ( 2 ) ∥ 2 ] ≤ 2 p ∥ ∇ f ( x ) ∥ 2 + p 2 L 2 r 2 2 . \mathbb{E}\left[ \left\| \tilde{G}_f^{(2)} \right\|^2 \right] \leq 2p \|\nabla f(\mathbf{x})\|^2 + \frac{p^2 L^2 r^2}{2}.

E [ G ~ f ( 2 ) 2 ] ≤ 2 p ∥∇ f ( x ) ∥ 2 + 2 p 2 L 2 r 2 .

关键结论 :方差不再依赖 r − 2 r^{-2} r − 2 r → 0 r \to 0 r → 0 2 p ∥ ∇ f ∥ 2 2p \|\nabla f\|^2 2 p ∥∇ f ∥ 2 有界且可控 。

收敛性分析

引理3表明,任一两点梯度估计器的二阶矩在 r → 0 r \to 0 r → 0 r r r

考虑 ZO-SGD 迭代:

x k + 1 = x k − α k G ~ f ( 2 ) ( x k ; r k , z k ) . \mathbf{x}_{k+1} = \mathbf{x}_k - \alpha_k \tilde{G}_f^{(2)}(\mathbf{x}_k; r_k, \mathbf{z}_k).

x k + 1 = x k − α k G ~ f ( 2 ) ( x k ; r k , z k ) .

设 f f f 凸 且 L L L -光滑 ,存在最优解 x ∗ \mathbf{x}^* x ∗ F k = σ ( x 0 , … , x k ) \mathcal{F}_k = \sigma(\mathbf{x}_0, \dots, \mathbf{x}_k) F k = σ ( x 0 , … , x k )

迭代展开:

E [ ∥ x k + 1 − x ∗ ∥ 2 ∣ F k ] = ∥ x k − x ∗ ∥ 2 − 2 α k ⟨ x k − x ∗ , ∇ f r k ( x k ) ⟩ + α k 2 E [ ∥ G ~ f ( 2 ) ∥ 2 ∣ F k ] . \begin{aligned}

\mathbb{E}\left[ \|\mathbf{x}_{k+1} - \mathbf{x}^*\|^2 \mid \mathcal{F}_k \right]

&= \|\mathbf{x}_k - \mathbf{x}^*\|^2 - 2\alpha_k \langle \mathbf{x}_k - \mathbf{x}^*, \nabla f_{r_k}(\mathbf{x}_k) \rangle \\

&\quad + \alpha_k^2 \mathbb{E}\left[ \|\tilde{G}_f^{(2)}\|^2 \mid \mathcal{F}_k \right].

\end{aligned}

E [ ∥ x k + 1 − x ∗ ∥ 2 ∣ F k ] = ∥ x k − x ∗ ∥ 2 − 2 α k ⟨ x k − x ∗ , ∇ f r k ( x k )⟩ + α k 2 E [ ∥ G ~ f ( 2 ) ∥ 2 ∣ F k ] .

利用凸性:⟨ x k − x ∗ , ∇ f r k ( x k ) ⟩ ≥ f r k ( x k ) − f r k ( x ∗ ) \langle \mathbf{x}_k - \mathbf{x}^*, \nabla f_{r_k}(\mathbf{x}_k) \rangle \geq f_{r_k}(\mathbf{x}_k) - f_{r_k}(\mathbf{x}^*) ⟨ x k − x ∗ , ∇ f r k ( x k )⟩ ≥ f r k ( x k ) − f r k ( x ∗ ) f r k ( x ) ≤ f ( x ) + L r k 2 2 f_{r_k}(\mathbf{x}) \leq f(\mathbf{x}) + \frac{L r_k^2}{2} f r k ( x ) ≤ f ( x ) + 2 L r k 2

− ⟨ x k − x ∗ , ∇ f r k ⟩ ≤ f ( x ∗ ) − f ( x k ) + L r k 2 . - \langle \mathbf{x}_k - \mathbf{x}^*, \nabla f_{r_k} \rangle \leq f(\mathbf{x}^*) - f(\mathbf{x}_k) + L r_k^2.

− ⟨ x k − x ∗ , ∇ f r k ⟩ ≤ f ( x ∗ ) − f ( x k ) + L r k 2 .

又因 f f f ∥ ∇ f ( x k ) ∥ 2 ≤ 2 L ( f ( x k ) − f ( x ∗ ) ) \|\nabla f(\mathbf{x}_k)\|^2 \leq 2L (f(\mathbf{x}_k) - f(\mathbf{x}^*)) ∥∇ f ( x k ) ∥ 2 ≤ 2 L ( f ( x k ) − f ( x ∗ ))

代入方差界后可得:

E [ ∥ x k + 1 − x ∗ ∥ 2 ∣ F k ] ≤ ∥ x k − x ∗ ∥ 2 − 2 α k ( 1 − 2 α k p L ) ( f ( x k ) − f ( x ∗ ) ) + α k L r k 2 + α k 2 p 2 L 2 r k 2 2 . \mathbb{E}\left[ \|\mathbf{x}_{k+1} - \mathbf{x}^*\|^2 \mid \mathcal{F}_k \right]

\leq \|\mathbf{x}_k - \mathbf{x}^*\|^2 - 2\alpha_k (1 - 2\alpha_k p L) (f(\mathbf{x}_k) - f(\mathbf{x}^*)) + \alpha_k L r_k^2 + \alpha_k^2 \frac{p^2 L^2 r_k^2}{2}.

E [ ∥ x k + 1 − x ∗ ∥ 2 ∣ F k ] ≤ ∥ x k − x ∗ ∥ 2 − 2 α k ( 1 − 2 α k p L ) ( f ( x k ) − f ( x ∗ )) + α k L r k 2 + α k 2 2 p 2 L 2 r k 2 .

对 k = 0 k = 0 k = 0 K K K

2 ∑ k = 0 K α k ( 1 − 2 α k p L ) E [ f ( x k ) − f ( x ∗ ) ] ≤ ∥ x 0 − x ∗ ∥ 2 + ∑ k = 0 K ( α k L r k 2 + α k 2 p 2 L 2 r k 2 2 ) . 2 \sum_{k=0}^K \alpha_k (1 - 2\alpha_k p L) \mathbb{E}[f(\mathbf{x}_k) - f(\mathbf{x}^*)]

\leq \|\mathbf{x}_0 - \mathbf{x}^*\|^2 + \sum_{k=0}^K \left( \alpha_k L r_k^2 + \alpha_k^2 \frac{p^2 L^2 r_k^2}{2} \right).

2 k = 0 ∑ K α k ( 1 − 2 α k p L ) E [ f ( x k ) − f ( x ∗ )] ≤ ∥ x 0 − x ∗ ∥ 2 + k = 0 ∑ K ( α k L r k 2 + α k 2 2 p 2 L 2 r k 2 ) .

取 α k = α = c 2 p L \alpha_k = \alpha = \frac{c}{2pL} α k = α = 2 p L c 0 < c < 1 0 < c < 1 0 < c < 1 r k = r r_k = r r k = r

1 K + 1 ∑ k = 0 K E [ f ( x k ) − f ( x ∗ ) ] ≤ p L ∥ x 0 − x ∗ ∥ 2 c ( 1 − c ) ( K + 1 ) + L r 2 2 ( 1 + c p 4 ) . \frac{1}{K+1} \sum_{k=0}^K \mathbb{E}[f(\mathbf{x}_k) - f(\mathbf{x}^*)]

\leq \frac{p L \|\mathbf{x}_0 - \mathbf{x}^*\|^2}{c(1-c)(K+1)} + \frac{L r^2}{2} \left(1 + \frac{c p}{4} \right).

K + 1 1 k = 0 ∑ K E [ f ( x k ) − f ( x ∗ )] ≤ c ( 1 − c ) ( K + 1 ) p L ∥ x 0 − x ∗ ∥ 2 + 2 L r 2 ( 1 + 4 c p ) .

若取 r k = O ( 1 / k + 1 ) r_k = \mathcal{O}(1/\sqrt{k+1}) r k = O ( 1/ k + 1 ) ∑ r k 2 = O ( log K ) \sum r_k^2 = \mathcal{O}(\log K) ∑ r k 2 = O ( log K ) O ( p / K + log K / K ) = O ( p / K ) \mathcal{O}(p/K + \log K / K) = \mathcal{O}(p/K) O ( p / K + log K / K ) = O ( p / K )

最终结论(凸情形) :E [ f ( x ˉ ) − f ( x ∗ ) ] ≤ ϵ \mathbb{E}[f(\bar{\mathbf{x}}) - f(\mathbf{x}^*)] \leq \epsilon E [ f ( x ˉ ) − f ( x ∗ )] ≤ ϵ K = O ( p / ϵ ) K = \mathcal{O}(p / \epsilon) K = O ( p / ϵ ) 2 次函数查询 ,总查询复杂度为 O ( p / ϵ ) \mathcal{O}(p / \epsilon) O ( p / ϵ )

非凸情形(一阶平稳点)

若 f f f L L L

1 K ∑ k = 0 K − 1 E [ ∥ ∇ f ( x k ) ∥ 2 ] ≤ O ( p K + r 2 ) . \frac{1}{K} \sum_{k=0}^{K-1} \mathbb{E}[\|\nabla f(\mathbf{x}_k)\|^2] \leq \mathcal{O}\left( \frac{p}{K} + r^2 \right).

K 1 k = 0 ∑ K − 1 E [ ∥∇ f ( x k ) ∥ 2 ] ≤ O ( K p + r 2 ) .

取 r = O ( 1 / K ) r = \mathcal{O}(1/\sqrt{K}) r = O ( 1/ K ) E [ ∥ ∇ f ( x k ) ∥ 2 ] → 0 \mathbb{E}[\|\nabla f(\mathbf{x}_k)\|^2] \to 0 E [ ∥∇ f ( x k ) ∥ 2 ] → 0 ZO-SGD 可收敛至一阶平稳点 。

单点梯度估计器与两点梯度估计器的对比总结

性质

单点估计器 G f ( 1 ) G_f^{(1)} G f ( 1 )

两点估计器 G ~ f ( 2 ) \tilde{G}_f^{(2)} G ~ f ( 2 )

期望 ∇ f r ( x ) \nabla f_r(\mathbf{x}) ∇ f r ( x ) ∇ f r ( x ) \nabla f_r(\mathbf{x}) ∇ f r ( x )

偏差 O ( L r ) \mathcal{O}(Lr) O ( L r ) O ( L r ) \mathcal{O}(Lr) O ( L r )

二阶矩 Ω ( r − 2 ) \Omega(r^{-2}) Ω ( r − 2 ) O ( p ∣ ∇ f ∣ 2 + p 2 r 2 ) \mathcal{O}(p |\nabla f|^2 + p^2 r^2) O ( p ∣∇ f ∣ 2 + p 2 r 2 )

r → 0 r \to 0 r → 0 时方差 爆炸 有界

收敛性 不保证(需强假设)

保证(凸:O ( p / ϵ ) \mathcal{O}(p/\epsilon) O ( p / ϵ )

实用价值 低(理论工具)

高(主流方法)

函数查询/次

1

2

迭代复杂度(凸)

(不实用)

O ( p / ϵ ) \mathcal{O}(p / \epsilon) O ( p / ϵ )

查询复杂度(凸)

—

O ( p / ϵ ) \mathcal{O}(p / \epsilon) O ( p / ϵ )

3.3 基于坐标的梯度估计器 (Coordinate-wise Gradient Estimator)

除了基于随机方向扰动的单点和两点梯度估计器,零阶优化还包括一类基于标准坐标基向量 的方法,称为基于坐标的梯度估计器 (coordinate-wise gradient estimator)。这类方法不依赖于高斯或球面均匀分布的随机向量,而是直接沿坐标轴方向进行扰动,从而估计偏导数。

形式

设 { e i } i = 1 p \{ \mathbf{e}_i \}_{i=1}^p { e i } i = 1 p R p \mathbb{R}^p R p e i \mathbf{e}_i e i i i i 前向差分 或中心差分 来估计每个偏导数 ∂ f / ∂ x i \partial f / \partial x_i ∂ f / ∂ x i

完整坐标前向差分估计器 (full coordinate-wise forward difference):

∇ ^ f ( x ) = ∑ i = 1 p f ( x + μ e i ) − f ( x ) μ e i . \hat{\nabla} f(\mathbf{x}) = \sum_{i=1}^p \frac{f(\mathbf{x} + \mu \mathbf{e}_i) - f(\mathbf{x})}{\mu} \mathbf{e}_i.

∇ ^ f ( x ) = i = 1 ∑ p μ f ( x + μ e i ) − f ( x ) e i .

完整坐标中心差分估计器 (full coordinate-wise central difference):

∇ ^ f ( x ) = ∑ i = 1 p f ( x + μ e i ) − f ( x − μ e i ) 2 μ e i . \hat{\nabla} f(\mathbf{x}) = \sum_{i=1}^p \frac{f(\mathbf{x} + \mu \mathbf{e}_i) - f(\mathbf{x} - \mu \mathbf{e}_i)}{2\mu} \mathbf{e}_i.

∇ ^ f ( x ) = i = 1 ∑ p 2 μ f ( x + μ e i ) − f ( x − μ e i ) e i .

在实际大规模问题中,通常不会一次性估计所有 p p p 随机坐标下降 (Stochastic Coordinate Descent)的思想,在每次迭代中随机均匀地选择一个坐标 i ∈ { 1 , … , p } i \in \{1, \dots, p\} i ∈ { 1 , … , p }

∇ ^ f ( x ) = f ( x + μ e i ) − f ( x − μ e i ) 2 μ e i , \hat{\nabla} f(\mathbf{x}) = \frac{f(\mathbf{x} + \mu \mathbf{e}_i) - f(\mathbf{x} - \mu \mathbf{e}_i)}{2\mu} \mathbf{e}_i,

∇ ^ f ( x ) = 2 μ f ( x + μ e i ) − f ( x − μ e i ) e i ,

这种方式每次迭代仅需 2 次函数查询 。正如综述 [Liu et al., 2020] 所指出的,当函数查询次数达到问题维度 p p p ∑ i = 1 p f ( x + μ e i ) − f ( x ) μ e i \sum_{i=1}^p \frac{f(x+\mu e_i) - f(x)}{\mu} e_i ∑ i = 1 p μ f ( x + μ e i ) − f ( x ) e i O ( p μ 2 ) \mathcal{O}(p\mu^2) O ( p μ 2 )

理论性质与误差分析

坐标估计器的分析基于确定性的泰勒展开,其误差性质可被严格刻画。

引理 4 **(坐标估计器的偏差) 假设 f f f L L L i i i

∣ f ( x + μ e i ) − f ( x − μ e i ) 2 μ − ∂ f ( x ) ∂ x i ∣ ≤ L μ 2 . \left| \frac{f(\mathbf{x} + \mu \mathbf{e}_i) - f(\mathbf{x} - \mu \mathbf{e}_i)}{2\mu} - \frac{\partial f(\mathbf{x})}{\partial x_i} \right| \leq \frac{L \mu}{2}.

2 μ f ( x + μ e i ) − f ( x − μ e i ) − ∂ x i ∂ f ( x ) ≤ 2 Lμ .

因此,完整梯度的欧氏范数误差为:

∥ ∇ ^ f ( x ) − ∇ f ( x ) ∥ 2 ≤ L μ p 2 . \left\| \hat{\nabla} f(\mathbf{x}) - \nabla f(\mathbf{x}) \right\|_2 \leq \frac{L \mu \sqrt{p}}{2}.

∇ ^ f ( x ) − ∇ f ( x ) 2 ≤ 2 Lμ p .

证明 :由 L L L f f f ξ 1 ∈ [ x , x + μ e i ] \xi_1 \in [\mathbf{x}, \mathbf{x}+\mu \mathbf{e}_i] ξ 1 ∈ [ x , x + μ e i ] ξ 2 ∈ [ x − μ e i , x ] \xi_2 \in [\mathbf{x}-\mu \mathbf{e}_i, \mathbf{x}] ξ 2 ∈ [ x − μ e i , x ]

f ( x + μ e i ) = f ( x ) + μ ∂ f ( x ) ∂ x i + μ 2 2 ∂ 2 f ( ξ 1 ) ∂ x i 2 , f(\mathbf{x} + \mu \mathbf{e}_i) = f(\mathbf{x}) + \mu \frac{\partial f(\mathbf{x})}{\partial x_i} + \frac{\mu^2}{2} \frac{\partial^2 f(\xi_1)}{\partial x_i^2},

f ( x + μ e i ) = f ( x ) + μ ∂ x i ∂ f ( x ) + 2 μ 2 ∂ x i 2 ∂ 2 f ( ξ 1 ) ,

f ( x − μ e i ) = f ( x ) − μ ∂ f ( x ) ∂ x i + μ 2 2 ∂ 2 f ( ξ 2 ) ∂ x i 2 . f(\mathbf{x} - \mu \mathbf{e}_i) = f(\mathbf{x}) - \mu \frac{\partial f(\mathbf{x})}{\partial x_i} + \frac{\mu^2}{2} \frac{\partial^2 f(\xi_2)}{\partial x_i^2}.

f ( x − μ e i ) = f ( x ) − μ ∂ x i ∂ f ( x ) + 2 μ 2 ∂ x i 2 ∂ 2 f ( ξ 2 ) .

两式相减并整理,利用 ∣ ∂ 2 f ∂ x i 2 ∣ ≤ L \left| \frac{\partial^2 f}{\partial x_i^2} \right| \leq L ∂ x i 2 ∂ 2 f ≤ L

在随机坐标下降 的框架下,每次迭代随机选择一个坐标 i ∼ U n i f ( { 1 , … , p } ) i \sim \mathrm{Unif}(\{1,\dots,p\}) i ∼ Unif ({ 1 , … , p }) g ^ = p 2 μ ( f ( x + μ e i ) − f ( x − μ e i ) ) e i \hat{g} = \frac{p}{2\mu} (f(\mathbf{x} + \mu \mathbf{e}_i) - f(\mathbf{x} - \mu \mathbf{e}_i)) \mathbf{e}_i g ^ = 2 μ p ( f ( x + μ e i ) − f ( x − μ e i )) e i 期望 为:

E i [ g ^ ] = ∑ i = 1 p 1 p ⋅ p 2 μ ( f ( x + μ e i ) − f ( x − μ e i ) ) e i = ∇ ^ f ( x ) , \mathbb{E}_i[\hat{g}] = \sum_{i=1}^p \frac{1}{p} \cdot \frac{p}{2\mu} (f(\mathbf{x} + \mu \mathbf{e}_i) - f(\mathbf{x} - \mu \mathbf{e}_i)) \mathbf{e}_i = \hat{\nabla} f(\mathbf{x}),

E i [ g ^ ] = i = 1 ∑ p p 1 ⋅ 2 μ p ( f ( x + μ e i ) − f ( x − μ e i )) e i = ∇ ^ f ( x ) ,

即完整坐标梯度估计。因此,随机坐标下降可以看作是完整梯度的一个无偏随机采样,其方差 来源于坐标选择的随机性,而非函数查询的噪声。这使得其在实践中具有良好的稳定性和样本效率。

关键优势 :坐标估计器的误差是确定性的 ,不依赖于随机扰动的方差。在光滑性假设下,其估计值在每次实现中都更接近真实偏导数。当问题具有梯度稀疏性 或可分离结构 时,该方法尤为高效。

应用与算法实例

基于坐标的梯度估计是零阶随机坐标下降 (Zeroth-Order Stochastic Coordinate Descent, ZO-SCD)算法的核心。该方法特别适用于:

高维但有效维度低 (gradient sparsity)的问题;可并行化 的场景,因为不同坐标的更新可以异步进行;结构化优化问题 ,如带有 ℓ 1 \ell_1 ℓ 1

综上,零阶梯度估计的三大基本范式可总结如下:

方法

扰动类型

查询次数/次迭代

主要优势

主要考虑

单点估计器 G f ( 1 ) G_f^{(1)} G f ( 1 ) 随机方向

1

理论简洁

方差爆炸,不实用

两点估计器 G ~ f ( 2 ) \tilde{G}_f^{(2)} G ~ f ( 2 ) 随机方向

2

方差可控,通用性强

查询复杂度 O ( p / ϵ ) \mathcal{O}(p/\epsilon) O ( p / ϵ )

坐标估计器 坐标基向量

2 2 2 2 p 2p 2 p 误差确定性小,适合稀疏/并行

全梯度查询成本高,需采样策略

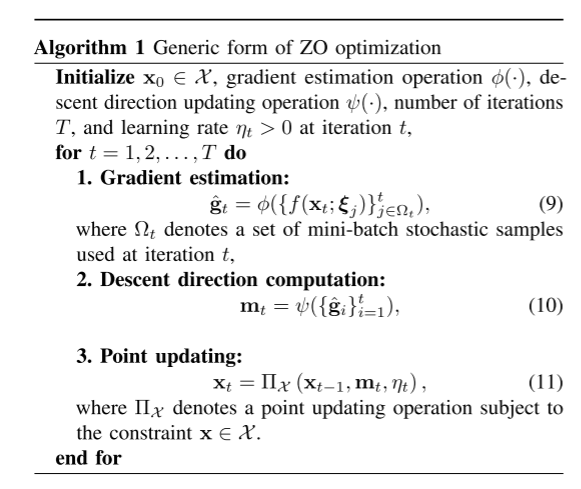

四、零阶优化算法

大多数零阶优化(ZOO)算法模仿其一阶对应物(如梯度下降),采用一个统一的三步迭代框架 :

梯度估计 (Gradient Estimation) :利用黑盒函数值 f ( x ) f(x) f ( x ) g ^ t \hat{g}_t g ^ t 下降方向计算 (Descent Direction Computation) :基于当前及历史的梯度估计,计算一个下降方向 m t m_t m t 点更新 (Point Updating) :根据下降方向和学习率,更新决策变量 x t x_t x t

这个框架是许多具体 ZO 算法的基础,包括 ZO-SGD、ZO-SCD、ZO-SVRG 等。

4.1 通用算法框架

注释 :

ϕ ( ⋅ ) \phi(\cdot) ϕ ( ⋅ ) ψ ( ⋅ ) \psi(\cdot) ψ ( ⋅ ) g ^ t \hat{g}_t g ^ t Π X \Pi_{\mathcal{X}} Π X X \mathcal{X} X

4.2 常见 ZO 算法实例

无约束优化

在无约束问题 min x ∈ R p f ( x ) \min_{x \in \mathbb{R}^p} f(x) min x ∈ R p f ( x )

ZO-SGD (Zeroth-Order Stochastic Gradient Descent)

下降方向 :m t = g ^ t m_t = \hat{g}_t m t = g ^ t 点更新 :x t = x t − 1 − η t m t x_t = x_{t-1} - \eta_t m_t x t = x t − 1 − η t m t 特点 :这是最基础的 ZO 算法,其收敛性已在前文分析,查询复杂度为 O ( p / ϵ ) \mathcal{O}(p/\epsilon) O ( p / ϵ )

ZO-SVRG (Zeroth-Order Stochastic Variance Reduced Gradient)

下降方向 :m t = g ^ t − g ~ t + E [ g ~ t ] m_t = \hat{g}_t - \tilde{g}_t + \mathbb{E}[\tilde{g}_t] m t = g ^ t − g ~ t + E [ g ~ t ] g ~ t \tilde{g}_t g ~ t 点更新 :同 ZO-SGD。特点 :通过控制变量技术降低梯度估计的方差,从而加速收敛,尤其在后期迭代中效果显著。

4.2 约束优化

当优化问题包含约束 x ∈ X x \in \mathcal{X} x ∈ X X \mathcal{X} X

ZO-PSGD (Zeroth-Order Projected SGD)

下降方向 :m t = g ^ t m_t = \hat{g}_t m t = g ^ t 点更新 :x t = Π X ( x t − 1 − η t m t ) x_t = \Pi_{\mathcal{X}}(x_{t-1} - \eta_t m_t) x t = Π X ( x t − 1 − η t m t ) Π X \Pi_{\mathcal{X}} Π X X \mathcal{X} X 欧氏投影 。特点 :约束优化中最直接的推广,适用于简单的凸约束集(如 ℓ 1 / ℓ 2 \ell_1/\ell_2 ℓ 1 / ℓ 2

ZO-SMD (Zeroth-Order Stochastic Mirror Descent)

下降方向 :m t = g ^ t m_t = \hat{g}_t m t = g ^ t 点更新 :基于Bregman 距离 (而非欧氏距离)的镜像映射。当 Bregman 距离为 1 2 ∥ x − y ∥ 2 \frac{1}{2}\|x-y\|^2 2 1 ∥ x − y ∥ 2 特点 :通过选择合适的距离生成函数 h ( ⋅ ) h(\cdot) h ( ⋅ )

ZO-AdaMM (Zeroth-Order Adaptive Momentum Method)

下降方向 :采用自适应动量 形式(类似 Adam),即 m t = β 1 m t − 1 + ( 1 − β 1 ) g ^ t m_t = \beta_1 m_{t-1} + (1-\beta_1)\hat{g}_t m t = β 1 m t − 1 + ( 1 − β 1 ) g ^ t 点更新 :使用马氏距离 (Mahalanobis distance)下的投影。特点 :能平衡收敛速度与精度,在黑盒对抗攻击等任务中表现出色。

4.3 复合优化

复合优化问题形式为 min x f ( x ) + g ( x ) \min_x f(x) + g(x) min x f ( x ) + g ( x ) f f f g g g ℓ 1 \ell_1 ℓ 1

ZO-ProxSGD / ZO-ADMM

下降方向 :m t = g ^ t m_t = \hat{g}_t m t = g ^ t 点更新 :不再使用投影 ,而是调用近端算子 (Proximal Operator):x t = p r o x η t g ( x t − 1 − η t m t ) x_t = \mathrm{prox}_{\eta_t g}(x_{t-1} - \eta_t m_t) x t = prox η t g ( x t − 1 − η t m t ) 特点 :这类算法能高效处理非光滑正则项,在黑盒对抗攻击 (g g g ℓ ∞ \ell_\infty ℓ ∞ 在线传感器管理 (g g g

五、应用场景

零阶优化的核心价值在于处理梯度不可用或不可信的黑盒优化问题 。以下几类典型场景凸显了其不可替代性:

黑盒对抗攻击与可解释性 。在评估深度神经网络的鲁棒性时,攻击者或审计者往往只能通过 API 接口获取模型的输入-输出对,内部梯度信息完全不可见。在此设定下,传统的白盒攻击方法失效。零阶优化通过仅查询函数值,成功生成能诱导模型误分类的对抗样本。同样,在为复杂模型提供解释时(如回答“模型为何做出此预测?”),若模型以黑盒形式提供(如商业 API),ZO 方法能绕过梯度计算,生成模型无关的局部解释。

强化学习中的策略搜索 。在无模型强化学习中,传统策略梯度方法需在高维动作空间中进行探索,其方差随轨迹长度急剧增长,导致样本效率低下。零阶策略搜索则将优化视角从动作空间转移到策略参数空间 ,直接通过有限差分估计策略参数的梯度。其探索复杂度仅取决于策略参数的维度,与动作空间维度和轨迹长度解耦,从而在高维任务中展现出显著优势。

在线传感器管理 。在智能电网、无线传感网络等系统中,优化目标常涉及大规模矩阵的行列式(如 log det \log\det log det

自动化机器学习 (AutoML)。贝叶斯优化(BO)是 AutoML 的核心,但其内部需反复优化高斯过程(GP)的超参数,而这一过程本身依赖于对高维非凸函数求梯度。零阶优化可直接替代这一内部求解器,仅通过验证集性能(函数值)来优化超参数,从而显著加速整个 AutoML 流程。

这些应用共同表明,零阶优化已成为连接黑盒现实世界 与智能优化算法 的关键桥梁。

六、零阶优化(ZO)当前面临的主要问题与挑战

非光滑目标函数 随机平滑 (如双随机化)或模型基插值 (如信赖域)缓解,但前者增加查询复杂度,后者引入额外计算开销。黑盒约束处理 X \mathcal{X} X 障碍函数 或增广拉格朗日 将其融入目标函数,但会改变原问题结构并带来超参调优难题。隐私保护与分布式学习 形式化地 (如差分隐私)?在联邦学习中,ZO能否同时兼顾隐私性、鲁棒性 (Byzantine容错)与通信效率 仍是开放问题。与自动微分 (AD)无缝融合 ZO估计与AD框架,以构建端到端可训练系统,尚缺系统性方法。离散变量优化 原生离散ZO算法 ,或设计更有效的连续-离散映射机制。紧致收敛率 O ( d / ϵ ) \mathcal{O}(d/\epsilon) O ( d / ϵ ) 带约束/非凸/非光滑 等更一般情形,最优收敛率及下界仍不明确,理论与实践存在鸿沟。

参考文献

Y. Tang, “Introduction to Zeroth-Order Optimization,” 2022.

S. Liu, P.-Y. Chen, B. Kailkhura, G. Zhang, A. O. Hero III, and P. K. Varshney, “A primer on zeroth-order optimization in signal processing and machine learning: Principles, recent advances, and applications,” IEEE Signal Processing Magazine, vol. 37, no. 5, pp. 43–54, 2020.

Y. Shu, Q. Zhang, K. He, and Z. Dai, “Refining adaptive zeroth-order optimization at ease,” in Proceedings of the 42nd International Conference on Machine Learning (ICML), 2025 .

Y. Nesterov and V. Spokoiny, “Random gradient-free minimization of convex functions,” Foundations of Computational Mathematics, vol. 17, no. 2, pp. 527–566, 2017.

零阶优化算法 - 知乎